出典: 量子ビットAI のコンピューティング能力が今ほど注目を集めていることはありません。大型モデルのトレンドが出現して以来、わずか数か月で大型モデルの数と規模は飛躍的に増加しました。数百億、数千億の大規模モデルが数十に急増し、兆パラメータの大規模モデルが正式に誕生しました。**このような規模の変化の下では、コンピューティング能力に対する需要は急激な変化を示します**。モデル レベルの企業は、ほぼあらゆるコストをかけてコンピューティング パワー サービスを利用しています。Nvidia の市場価値はかつて 1 兆米ドルを超え、クラウド コンピューティング市場は加速度的に再形成されています... AIGC産業の発展にとって、コンピューティングパワーが水力や石油と同じ基礎エネルギーであることは疑いの余地がありません。AIGC 時代の前兆の後、コンピューティングパワー業界をどのように理解するかが特に重要です。企業にはどのようなコンピューティング能力が必要ですか? AIGC の台頭により、コンピューティングパワー業界にどのような変化が起こるでしょうか?現在のコンピューティングパワー市場の構成は何ですか?**「AIGC コンピューティング パワー パノラマおよびトレンド レポート」** は、これらの問題を理解するのに役立ちます。報告書の中で、キュービットシンクタンクはAIGCコンピューティング能力と産業チェーンの構成を系統的に分析し、さらにAIGCコンピューティング能力の**5つの新たなトレンド**と**3段階**の発展予測を指摘した。 。 主なアイデアには次のようなものがあります。* AIGC によって推進され、チップは高性能と大規模なコンピューティング能力を競い合い、新しいコンピューティング アーキテクチャを導入します。* AI サーバーが突然起動し、ボーナス カーブが最初にトレーニングされ、次に推論されます。* MaaS はクラウド サービス パラダイムを再構築し、AIGC ビジネス モデル クローズド ループ。* AI モデルのオールインワン マシンが登場する準備が整っており、従来の業界は「すぐに使える」状態です。* インテリジェント コンピューティング センターが AIGC の運営を支援し、コンピューティング パワーのリース モデルが新しいソリューションになりました。……一つずつ詳細を見ていきましょう。## **国内サーバーメーカーの事業成長率は30%を超える**現在の業界の現状を分析すると、業界の本体には主に次のものが含まれます。* チップ※AIサーバー(クラスター)* クラウドコンピューティング### **チップ層: AIGC 2 つのルートがコンピューティング能力を提供します**コンピューティング チップでは、AIGC 業界のコンピューティング能力のニーズを満たすため、現在業界には 2 つの主流ルートがあります。1つはNvidiaに代表される**ユニバーサルチップ**と呼ばれるGPU路線です。もう1つはファーウェイやカンブリアンに代表されるASICルートで、**特殊チップルート**と呼ばれます。現時点では、これら 2 つのルートには異なるタイプのプレーヤーが集まり、彼らが引き受けるコンピューティング タスクも異なります。汎用チップルートの下で、さまざまなコンピューティングタスクを完了でき、大規模な並列コンピューティングに適しています。つまり、**AIGC の現在の計算能力には汎用チップ (GPU) の方が適しています**。専用ルートの利点は、特定のシナリオにおけるエネルギー効率の向上に反映されます。専用チップは特殊なタスクまたはカスタマイズされたタスクを実行するように設計されているため、特定のシナリオでは汎用チップよりも優れたエネルギー効率比とコンピューティング効率を達成できます**。専用チップは特定のシナリオでより高いコンピューティング効率を実現できるため、インターネットや他のクラウド ベンダーが独自のチップを開発する際に選択する技術的なルートにもなっています。通常、インターネット クラウド メーカーの自社開発チップは主に自社製品に提供され、自社のエコロジーでチップのパフォーマンスを最大限に発揮することが重視されています。 ### **サーバー層: 主にインターネット顧客に基づいたビジネスの成長は明らかです**AIGC のハイパフォーマンス コンピューティングに対する需要により、AI サーバーはサーバー分野で最も急成長しているセグメントとなっています。GPT-3 などの大規模なモデルのトレーニングには大量のコンピューティング リソースとメモリが必要で、通常、トレーニングを高速化するために数千、さらには数万の GPU が使用されます。これらの計算にはチップのパフォーマンスに対する非常に高い要件が求められるため、大規模な並列コンピューティングと高速データ転送をサポートするには専用のハードウェアとソフトウェアが必要です。AI サーバーは、人工知能のワークロードを処理するために特別に設計されたサーバーであり、専用のハードウェア アクセラレータ (GPU、TPU など)、高速ネットワーク接続およびストレージを使用して、高性能コンピューティング機能を提供します。対照的に、CPU (汎用サーバー) は通常、AIGC の高度なコンピューティング能力の需要を満たすことができず、そのコンピューティング能力、メモリ、およびストレージ容量は通常低いです。さらに、CPU には通常、高速コンピューティングを提供する専用のハードウェア アクセラレータがありません。したがって、大規模なモデルのトレーニングでは、コンピューティング サービスを提供する AI サーバー クラスターに依存する必要があります。Qubit Think Tank の調査によると、今年の AIGC 発生後、国内のサーバー メーカーは概して 30% 以上業績を伸ばしています**。最近、TrendForce は、2022 年から 2026 年までの AI サーバー出荷の年間複合成長率も 22% に引き上げました。 AIサーバー事業の急増の陰で、最大の買い手は依然としてインターネット企業だ。2022 年には、**ByteDance**、**Tencent**、**Alibaba**、**Baidu** などの大手メーカーが AI サーバーの調達割合において主な購入者となるでしょう。今年は、大規模モデルの研究開発への熱意が下流のインターネット企業の購入需要を押し上げ、依然としてAIサーバーの最大の購入者となっている。 ### **クラウド コンピューティング: MaaS のサービス モデルの再構築、新旧のプレーヤーが競争力を再構築**MaaS モデルは Ali によって最初に提案され、その後、大手インターネット企業や人工知能企業 (SenseTime など) が MaaS モデルを導入しました。また、インターネット大手やファーウェイなどの企業はすでに自社開発チップをMaaS拠点の建設に活用している。2023年には、国内の大手クラウドメーカーが大規模なモデルベースに基づく独自のMaaSプラットフォームを相次いで立ち上げ、コンピューティングリソースが限られ、専門的な経験が不足している企業向けにワンストップのMaaSサービスを提供する予定だ。クラウド ベンダーにとって、MaaS サービスの主な目的は **顧客が業界固有の大規模モデルを迅速に構築できるようにする**ことです。これに基づいて、クラウドベンダー間の競争の次元は、コンピューティングパワーインフラストラクチャ、一般的な大規模モデル能力、AIプラットフォーム/ツール能力に変化しました。 ### **インテリジェント コンピューティング センターの状況: インフラレベルの AI コンピューティング電源を供給し、地域経済成長の新たなエンジンを創出**コンピューティング機器流通の観点から見ると、サーバーおよびAIサーバー市場では、北京、広東、浙江、上海、江蘇がトップ5にランクインしており、(サーバーとAIサーバーの)合計市場シェアは75%、90%となっている。 (2021年データ) 。供給の観点から見ると、インテリジェント コンピューティング センターのほとんどは **東部** と **中部** の州にあり、AIGC ビジネスでは大量のデータを処理する必要があるため、各地域のコンピューティング電力リソースのコストが高くなっています。東**。大規模なモデルのトレーニングなどの高いコンピューティング要件を伴うタスクを西部リージョンに移動すると、「**東部データ トレーニング**」が形成され、コストが効果的に削減され、コンピューティング ネットワーク リソースの最適な総合コストが達成されます。具体的には、演算能力需要の需給アンバランスなどの問題を解決するには、演算能力スケジューリングにより東部地域の演算能力やデータ処理タスクをより低コストで西部地域に移転する必要がある。その中でも、東西間の相互接続ネットワークとハブノード間の直接接続ネットワークの最適化が、計算能力のスケジューリングレベルを向上させる鍵となります。需要の観点から見ると、AIGC のコンピューティング能力に対する需要は主に、北京、天津、河北地域、長江デルタ、大湾区に主に分布する AIGC 大型モデルを開発するメーカーから来ています。## **チップサーバー革命が起こりつつある**大規模モデルの傾向により、コンピューティング能力に対する新たな要件が提示され、基盤となるハードウェアに新たな変化が生じます。チップとサーバーの 2 つのレベルを見てみましょう。### **チップレベル**現時点では、高性能チップの中で Nvidia A100 が絶対的な優位性を持っており、A100 は中国に在庫があるだけで増加はなく、国内市場は国内 GPU メーカーにさらなるチャンスを与えることになります**。さらに、チップ ファウンドリ レベルでは、現在 7nm 以上のプロセスを引き受けることができる国内ファウンドリは存在せず、ほとんどの GPU メーカーは、より高いパフォーマンス指標を達成するために成熟したプロセス + 高度なパッケージング ソリューションを選択しています。サーバー クラスター レベルでは、マルチカード、マルチマシンの並列コンピューティングと高性能ネットワークを通じて高性能コンピューティングが実現されます。Nvidia が構築したハードウェア製品 + CUDA エコロジーは 10 年で突破するのは難しいため、将来、高性能 GPU が制限されると、ハードウェア層には 2 つの主要なソリューションが存在するとアナリストは予測しています。 GPU + チップ間インターコネクト技術を開発して、超並列コンピューティング** を実現します。もう 1 つは、フォン ノイマン アーキテクチャから飛び出し、コンピューティング ユニットとストレージ ユニットを統合してコンピューティングのエネルギー効率を桁違いに向上させる **統合ストレージおよびコンピューティング アーキテクチャを開発**することです。ソフトウェア レベルでは、**スパース コンピューティング**と**高性能ネットワークの構築**が現在 2 つのソリューションです。スパースコンピューティングの革新はアルゴリズムレベルにも反映されており、無効なデータや冗長なデータ(通常、これらのデータは通常巨大です)を削除することにより、データの計算量が大幅に削減され、計算が高速化されます。高性能ネットワークを構築する目的は、大規模モデルのトレーニング時間を短縮することです。高性能ネットワークを構築することで、各計算ノードの通信帯域が超高くなり、トラフィック性能が数倍向上し、大規模モデルのトレーニング時間を短縮します。 ### **サーバーレベル**AI の大規模モデルのコンピューティング能力に対する需要は急激に増加しており、より高度な構成の AI サーバーが AIGC コンピューティング能力の主なキャリアとなっています。従来のサーバーと比較して、AI サーバーのコンピューティング、ストレージ、ネットワーク伝送機能はより高いレベルに達することができます。たとえば、8 つの GPU と 2 つの CPU を備えた NVIDIA DGX A100 サーバーの構成は、1 ~ 2 つの CPU を備えた従来のサーバーの構成よりもはるかに高くなっています。私の国では、インテリジェント コンピューティング センターは、人工知能 (大規模モデル) に計算能力リソースを提供する公共インフラストラクチャ プラットフォームであり、その計算能力ユニットは主に AI トレーニング サーバーと AI 推論サーバーです。大規模モデルの進化に伴い、将来の AI サーバーに対する主な需要はトレーニングから推論に移行します。 IDC の予測によると、2026 年までに AIGC のコンピューティング能力の 62.2% がモデル推論に使用されることになります。## **業界の変化は新たなビジネスチャンスを生み出す**さらに、AI 大規模モデルのトレンドはコンピューティングパワー業界に新たな機会をもたらし、新たなパラダイム、新たな製品、新たなインフラストラクチャーが出現しています。### **新しいゲーム ルール: MaaS のクラウド サービス パラダイムの再構築、AIGC ビジネス モデルのクローズド ループ**MaaS (Model as a Service) は、コンピューティング能力、アルゴリズム、およびアプリケーション層に大規模なモデルを埋め込み、アプリケーションをインテリジェント ベースと統合し、外部出力を統合します。MaaS の本質は、業界で共通の基本技術を洗練し、さまざまなアプリケーション シナリオのニーズを満たすサービスに統合することです。商用化の過程では、大規模モデルの機能とサポートするミドルウェア ツールが、企業がクラウド コンピューティング ベンダーに対して検討すべき新たな次元になります。クラウド コンピューティング サービスの能力を判断する基準は、コンピューティング パワー レベルから「クラウド インテリジェンス統合」能力に移り、コンピューティング パワー インフラストラクチャに加えて、コアの競争力はコンピューティング パワー、モデル、シーン アプリケーションを構築する能力に変化しました。標準化された製品に。 ### **新種: AI モデルのオールインワン マシンが登場する準備が整い、従来の産業は「すぐに使える」 **AIモデルオールインワンマシンはソフトウェアとハードウェアを深く統合しており、企業のさまざまなニーズに応じて、対応する製品またはソリューションを事前にAIサーバー上に展開し、パッケージ化して完全なソリューションセットを形成します。AIモデル一体型マシンのコスト優位性は主に以下の3点に反映されます。* 1) 全体の購入価格は、ソフトウェア + ハードウェアを個別に購入する価格よりも安くなります。※2) 企業がサーバーを別途購入し、AI企業に引き渡してソフトウェアを導入するには時間がかかりますが、AIモデル一体型マシンはすぐに使用でき、配送コストの削減。*3) 必要なサーバーの数が大幅に削減され、お客様のスペースコストが節約されます。 ### **新しいインフラストラクチャ: インテリジェント コンピューティング センターが AIGC の運用を支援し、コンピューティング電力リース モードが新しいソリューションになります**コンピューティングパワーのリースモデルは、大規模モデル開発の敷居を効果的に下げることができ、十分なAIサーバーを購入する体力がない垂直産業の小規模モデル企業にとって、パブリックコンピューティングパワー基本プラットフォームは中小企業を支援します。独自の必要なモデルを構築します。企業はサーバーを購入する必要がなく、ブラウザを通じてコンピューティング パワー センターにアクセスし、コンピューティング パワー サービスを利用できます。中小企業にとっては、二次開発のためにクラウド ベンダーが構築した大規模なモデル ベースに依存する必要はなく、公共のコンピューティング パワー プラットフォームからコンピューティング パワー リソースを借りて、垂直産業の小規模なモデルを開発する必要があります。## **業界発展予測**要約すると、量子ビット シンクタンクは AIGC の将来の発展を予測しており、それは 3 つの段階に分けられます。※AIGCインフラ期間※AIGC開発期間※AIGC事業期間### **AIGC インフラストラクチャ期間**現在、AIGC モデル層のほとんどの企業は事前トレーニング段階にあり、チップの主な需要源は GPU です。初期段階では、高性能 GPU メーカーが最大の受益者となります。しかし、現時点では国内GPUメーカーとエヌビディアの間には大きな差があり、株式市場では最初に受益者が支配的となっている。したがって、現段階では国内のAIサーバーメーカーが有力なサプライヤーとなる。現在、国内のAIサーバー分野は不足している。 ### **AIGC 開発期間**中期段階 (5 年以内) では、コンピューティング パワー層はトレーニングから推論への移行プロセスとなります。この段階では、推論チップが主な需要側になります。 GPU の高い計算能力と高い消費電力、およびそれに伴う計算能力の浪費と比較して、推論チップはチップの計算効率比にさらに注意を払い、消費電力とコストをより適切に制御します。さらに、この段階は革新的なチップのチャンスでもあります。アナリストは、メモリコンピューティング統合チップ、脳に着想を得たチップ、シリコン光チップなどの市場機会が増えると予想している。推論段階では、トレーニング段階のクラウド コンピューティングよりもエッジ コンピューティングの方がチャンスが多くなります。まず、推論段階に相当するアプリケーションは多様化する傾向にあり、要件の多様化によりクラウドコンピューティングでは計算能力の浪費が増大し、計算効率が低下します。第 2 に、エッジ コンピューティングは、大規模なモデル推論に十分なコンピューティング能力を提供できます。この段階では、AIサーバーメーカーの配当時期は徐々にピークに達し、需要は低コストの汎用サーバーにシフトし、チップもGPUからNPU/ASIC/FPGA/CPUなどへ移行し、他の形態が混在することになる。国内の革新的なチップのルートの中で、** は統合されたストレージとコンピューティング アーキテクチャの開発に楽観的です**。 ### **AIGC営業期間**チップの根底にあるイノベーションの利点が明らかになり始めており、ストレージとコンピューティングの統合、フォトニックチップ、頭脳型チップなどの真に革新的なテクノロジーを備えたチップメーカーが市場での役割を高めています。AIGC のコンピューティング能力に必要なチップの種類はさらに多様です。この段階の企業は、コンピューティング能力の規模を考慮するだけでなく、コンピューティング能力をより包括的に考慮する必要があり、消費電力とコストがコンピューティング能力の規模を超え、各モデル層の企業が気にする指標になる可能性があります。## **レポートの取得**以下のリンクをクリックしてください。

AIGC コンピューティングパワーのパノラマとトレンドレポートがリリースされました! 1 つの記事では、AIGC のコンピューティング能力構成、業界チェーン、および 5 つの新しいトレンド判断を解釈しています。

出典: 量子ビット

AI のコンピューティング能力が今ほど注目を集めていることはありません。

大型モデルのトレンドが出現して以来、わずか数か月で大型モデルの数と規模は飛躍的に増加しました。

数百億、数千億の大規模モデルが数十に急増し、兆パラメータの大規模モデルが正式に誕生しました。

このような規模の変化の下では、コンピューティング能力に対する需要は急激な変化を示します。

モデル レベルの企業は、ほぼあらゆるコストをかけてコンピューティング パワー サービスを利用しています。Nvidia の市場価値はかつて 1 兆米ドルを超え、クラウド コンピューティング市場は加速度的に再形成されています...

AIGC 時代の前兆の後、コンピューティングパワー業界をどのように理解するかが特に重要です。

企業にはどのようなコンピューティング能力が必要ですか? AIGC の台頭により、コンピューティングパワー業界にどのような変化が起こるでしょうか?現在のコンピューティングパワー市場の構成は何ですか?

「AIGC コンピューティング パワー パノラマおよびトレンド レポート」 は、これらの問題を理解するのに役立ちます。

報告書の中で、キュービットシンクタンクはAIGCコンピューティング能力と産業チェーンの構成を系統的に分析し、さらにAIGCコンピューティング能力の5つの新たなトレンドと3段階の発展予測を指摘した。 。

一つずつ詳細を見ていきましょう。

国内サーバーメーカーの事業成長率は30%を超える

現在の業界の現状を分析すると、業界の本体には主に次のものが含まれます。

チップ層: AIGC 2 つのルートがコンピューティング能力を提供します

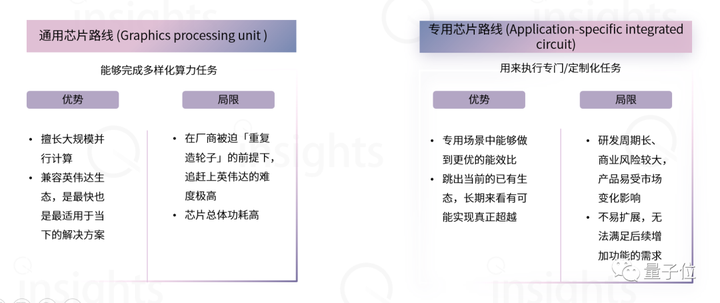

コンピューティング チップでは、AIGC 業界のコンピューティング能力のニーズを満たすため、現在業界には 2 つの主流ルートがあります。

1つはNvidiaに代表されるユニバーサルチップと呼ばれるGPU路線です。

もう1つはファーウェイやカンブリアンに代表されるASICルートで、特殊チップルートと呼ばれます。

現時点では、これら 2 つのルートには異なるタイプのプレーヤーが集まり、彼らが引き受けるコンピューティング タスクも異なります。

汎用チップルートの下で、さまざまなコンピューティングタスクを完了でき、大規模な並列コンピューティングに適しています。

つまり、AIGC の現在の計算能力には汎用チップ (GPU) の方が適しています。

専用ルートの利点は、特定のシナリオにおけるエネルギー効率の向上に反映されます。専用チップは特殊なタスクまたはカスタマイズされたタスクを実行するように設計されているため、特定のシナリオでは汎用チップよりも優れたエネルギー効率比とコンピューティング効率を達成できます**。

専用チップは特定のシナリオでより高いコンピューティング効率を実現できるため、インターネットや他のクラウド ベンダーが独自のチップを開発する際に選択する技術的なルートにもなっています。

通常、インターネット クラウド メーカーの自社開発チップは主に自社製品に提供され、自社のエコロジーでチップのパフォーマンスを最大限に発揮することが重視されています。

AIGC のハイパフォーマンス コンピューティングに対する需要により、AI サーバーはサーバー分野で最も急成長しているセグメントとなっています。

GPT-3 などの大規模なモデルのトレーニングには大量のコンピューティング リソースとメモリが必要で、通常、トレーニングを高速化するために数千、さらには数万の GPU が使用されます。

これらの計算にはチップのパフォーマンスに対する非常に高い要件が求められるため、大規模な並列コンピューティングと高速データ転送をサポートするには専用のハードウェアとソフトウェアが必要です。

AI サーバーは、人工知能のワークロードを処理するために特別に設計されたサーバーであり、専用のハードウェア アクセラレータ (GPU、TPU など)、高速ネットワーク接続およびストレージを使用して、高性能コンピューティング機能を提供します。

対照的に、CPU (汎用サーバー) は通常、AIGC の高度なコンピューティング能力の需要を満たすことができず、そのコンピューティング能力、メモリ、およびストレージ容量は通常低いです。さらに、CPU には通常、高速コンピューティングを提供する専用のハードウェア アクセラレータがありません。

したがって、大規模なモデルのトレーニングでは、コンピューティング サービスを提供する AI サーバー クラスターに依存する必要があります。

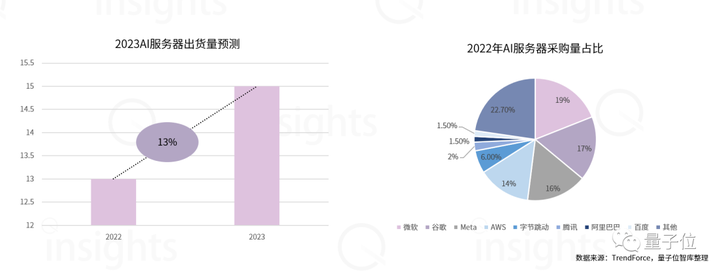

Qubit Think Tank の調査によると、今年の AIGC 発生後、国内のサーバー メーカーは概して 30% 以上業績を伸ばしています**。

最近、TrendForce は、2022 年から 2026 年までの AI サーバー出荷の年間複合成長率も 22% に引き上げました。 AIサーバー事業の急増の陰で、最大の買い手は依然としてインターネット企業だ。

2022 年には、ByteDance、Tencent、Alibaba、Baidu などの大手メーカーが AI サーバーの調達割合において主な購入者となるでしょう。今年は、大規模モデルの研究開発への熱意が下流のインターネット企業の購入需要を押し上げ、依然としてAIサーバーの最大の購入者となっている。

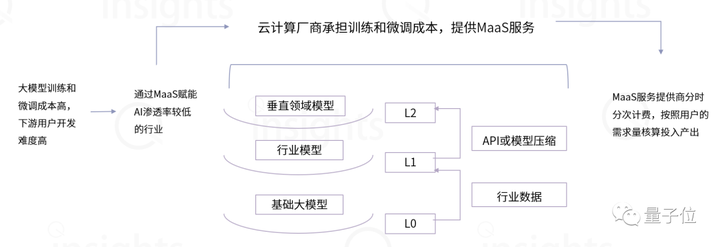

MaaS モデルは Ali によって最初に提案され、その後、大手インターネット企業や人工知能企業 (SenseTime など) が MaaS モデルを導入しました。

また、インターネット大手やファーウェイなどの企業はすでに自社開発チップをMaaS拠点の建設に活用している。

2023年には、国内の大手クラウドメーカーが大規模なモデルベースに基づく独自のMaaSプラットフォームを相次いで立ち上げ、コンピューティングリソースが限られ、専門的な経験が不足している企業向けにワンストップのMaaSサービスを提供する予定だ。

クラウド ベンダーにとって、MaaS サービスの主な目的は 顧客が業界固有の大規模モデルを迅速に構築できるようにすることです。これに基づいて、クラウドベンダー間の競争の次元は、コンピューティングパワーインフラストラクチャ、一般的な大規模モデル能力、AIプラットフォーム/ツール能力に変化しました。

コンピューティング機器流通の観点から見ると、サーバーおよびAIサーバー市場では、北京、広東、浙江、上海、江蘇がトップ5にランクインしており、(サーバーとAIサーバーの)合計市場シェアは75%、90%となっている。 (2021年データ) 。

供給の観点から見ると、インテリジェント コンピューティング センターのほとんどは 東部 と 中部 の州にあり、AIGC ビジネスでは大量のデータを処理する必要があるため、各地域のコンピューティング電力リソースのコストが高くなっています。東**。

大規模なモデルのトレーニングなどの高いコンピューティング要件を伴うタスクを西部リージョンに移動すると、「東部データ トレーニング」が形成され、コストが効果的に削減され、コンピューティング ネットワーク リソースの最適な総合コストが達成されます。

具体的には、演算能力需要の需給アンバランスなどの問題を解決するには、演算能力スケジューリングにより東部地域の演算能力やデータ処理タスクをより低コストで西部地域に移転する必要がある。その中でも、東西間の相互接続ネットワークとハブノード間の直接接続ネットワークの最適化が、計算能力のスケジューリングレベルを向上させる鍵となります。

需要の観点から見ると、AIGC のコンピューティング能力に対する需要は主に、北京、天津、河北地域、長江デルタ、大湾区に主に分布する AIGC 大型モデルを開発するメーカーから来ています。

チップサーバー革命が起こりつつある

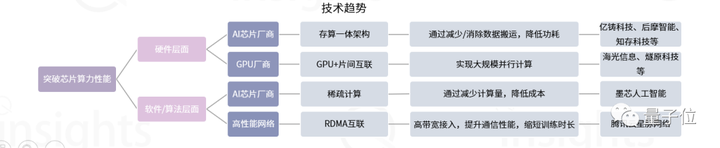

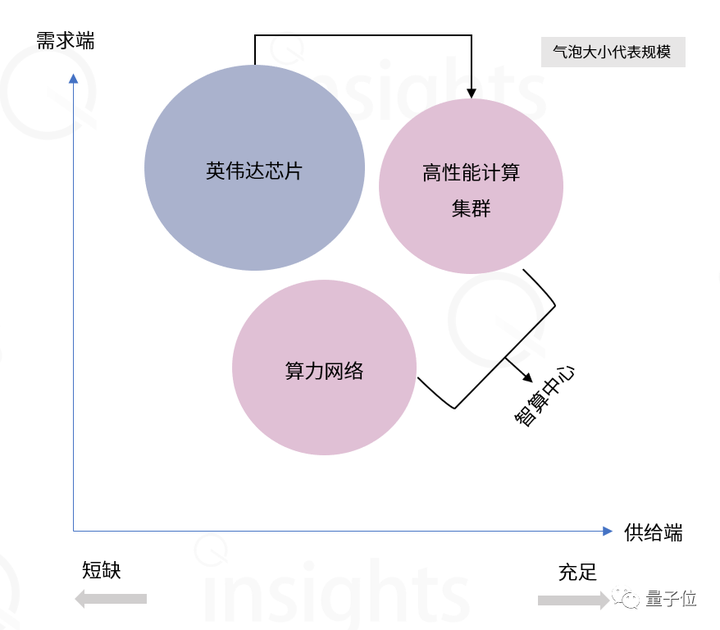

大規模モデルの傾向により、コンピューティング能力に対する新たな要件が提示され、基盤となるハードウェアに新たな変化が生じます。チップとサーバーの 2 つのレベルを見てみましょう。

チップレベル

現時点では、高性能チップの中で Nvidia A100 が絶対的な優位性を持っており、A100 は中国に在庫があるだけで増加はなく、国内市場は国内 GPU メーカーにさらなるチャンスを与えることになります**。

さらに、チップ ファウンドリ レベルでは、現在 7nm 以上のプロセスを引き受けることができる国内ファウンドリは存在せず、ほとんどの GPU メーカーは、より高いパフォーマンス指標を達成するために成熟したプロセス + 高度なパッケージング ソリューションを選択しています。

サーバー クラスター レベルでは、マルチカード、マルチマシンの並列コンピューティングと高性能ネットワークを通じて高性能コンピューティングが実現されます。

Nvidia が構築したハードウェア製品 + CUDA エコロジーは 10 年で突破するのは難しいため、将来、高性能 GPU が制限されると、ハードウェア層には 2 つの主要なソリューションが存在するとアナリストは予測しています。 GPU + チップ間インターコネクト技術を開発して、超並列コンピューティング** を実現します。

もう 1 つは、フォン ノイマン アーキテクチャから飛び出し、コンピューティング ユニットとストレージ ユニットを統合してコンピューティングのエネルギー効率を桁違いに向上させる 統合ストレージおよびコンピューティング アーキテクチャを開発することです。

ソフトウェア レベルでは、スパース コンピューティングと高性能ネットワークの構築が現在 2 つのソリューションです。

スパースコンピューティングの革新はアルゴリズムレベルにも反映されており、無効なデータや冗長なデータ(通常、これらのデータは通常巨大です)を削除することにより、データの計算量が大幅に削減され、計算が高速化されます。

高性能ネットワークを構築する目的は、大規模モデルのトレーニング時間を短縮することです。高性能ネットワークを構築することで、各計算ノードの通信帯域が超高くなり、トラフィック性能が数倍向上し、大規模モデルのトレーニング時間を短縮します。

AI の大規模モデルのコンピューティング能力に対する需要は急激に増加しており、より高度な構成の AI サーバーが AIGC コンピューティング能力の主なキャリアとなっています。

従来のサーバーと比較して、AI サーバーのコンピューティング、ストレージ、ネットワーク伝送機能はより高いレベルに達することができます。

たとえば、8 つの GPU と 2 つの CPU を備えた NVIDIA DGX A100 サーバーの構成は、1 ~ 2 つの CPU を備えた従来のサーバーの構成よりもはるかに高くなっています。

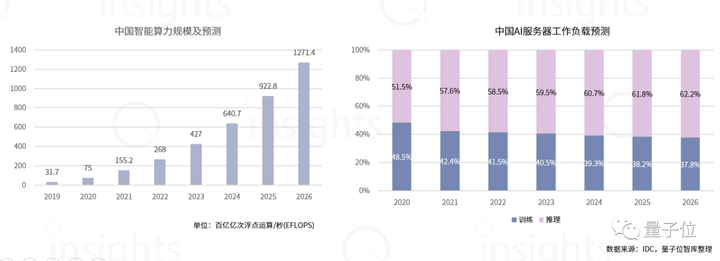

私の国では、インテリジェント コンピューティング センターは、人工知能 (大規模モデル) に計算能力リソースを提供する公共インフラストラクチャ プラットフォームであり、その計算能力ユニットは主に AI トレーニング サーバーと AI 推論サーバーです。

大規模モデルの進化に伴い、将来の AI サーバーに対する主な需要はトレーニングから推論に移行します。 IDC の予測によると、2026 年までに AIGC のコンピューティング能力の 62.2% がモデル推論に使用されることになります。

業界の変化は新たなビジネスチャンスを生み出す

さらに、AI 大規模モデルのトレンドはコンピューティングパワー業界に新たな機会をもたらし、新たなパラダイム、新たな製品、新たなインフラストラクチャーが出現しています。

新しいゲーム ルール: MaaS のクラウド サービス パラダイムの再構築、AIGC ビジネス モデルのクローズド ループ

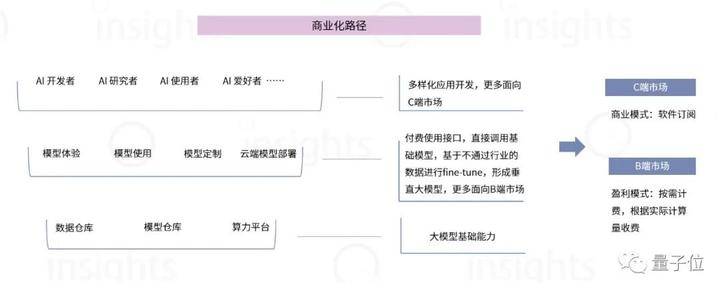

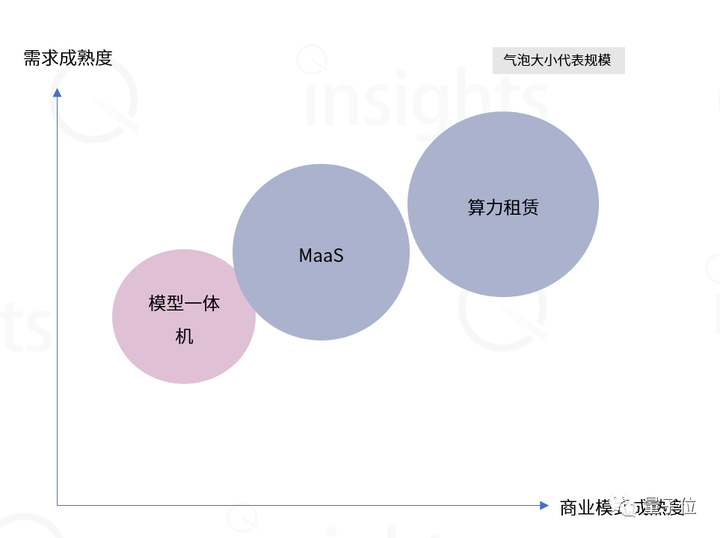

MaaS (Model as a Service) は、コンピューティング能力、アルゴリズム、およびアプリケーション層に大規模なモデルを埋め込み、アプリケーションをインテリジェント ベースと統合し、外部出力を統合します。

MaaS の本質は、業界で共通の基本技術を洗練し、さまざまなアプリケーション シナリオのニーズを満たすサービスに統合することです。

商用化の過程では、大規模モデルの機能とサポートするミドルウェア ツールが、企業がクラウド コンピューティング ベンダーに対して検討すべき新たな次元になります。

クラウド コンピューティング サービスの能力を判断する基準は、コンピューティング パワー レベルから「クラウド インテリジェンス統合」能力に移り、コンピューティング パワー インフラストラクチャに加えて、コアの競争力はコンピューティング パワー、モデル、シーン アプリケーションを構築する能力に変化しました。標準化された製品に。

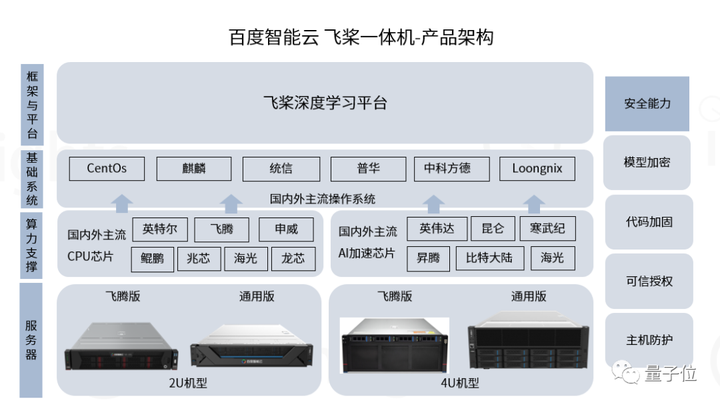

AIモデルオールインワンマシンはソフトウェアとハードウェアを深く統合しており、企業のさまざまなニーズに応じて、対応する製品またはソリューションを事前にAIサーバー上に展開し、パッケージ化して完全なソリューションセットを形成します。

AIモデル一体型マシンのコスト優位性は主に以下の3点に反映されます。

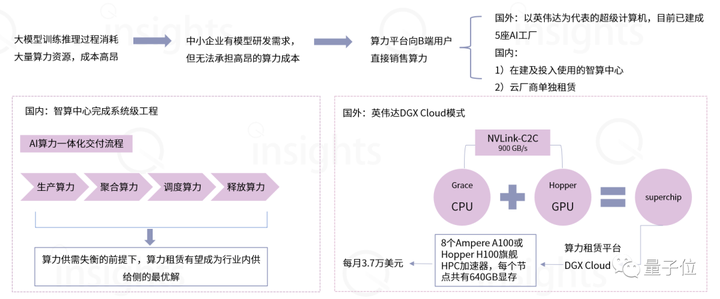

コンピューティングパワーのリースモデルは、大規模モデル開発の敷居を効果的に下げることができ、十分なAIサーバーを購入する体力がない垂直産業の小規模モデル企業にとって、パブリックコンピューティングパワー基本プラットフォームは中小企業を支援します。独自の必要なモデルを構築します。

企業はサーバーを購入する必要がなく、ブラウザを通じてコンピューティング パワー センターにアクセスし、コンピューティング パワー サービスを利用できます。

中小企業にとっては、二次開発のためにクラウド ベンダーが構築した大規模なモデル ベースに依存する必要はなく、公共のコンピューティング パワー プラットフォームからコンピューティング パワー リソースを借りて、垂直産業の小規模なモデルを開発する必要があります。

業界発展予測

要約すると、量子ビット シンクタンクは AIGC の将来の発展を予測しており、それは 3 つの段階に分けられます。

※AIGCインフラ期間 ※AIGC開発期間 ※AIGC事業期間

AIGC インフラストラクチャ期間

現在、AIGC モデル層のほとんどの企業は事前トレーニング段階にあり、チップの主な需要源は GPU です。

初期段階では、高性能 GPU メーカーが最大の受益者となります。

しかし、現時点では国内GPUメーカーとエヌビディアの間には大きな差があり、株式市場では最初に受益者が支配的となっている。

したがって、現段階では国内のAIサーバーメーカーが有力なサプライヤーとなる。現在、国内のAIサーバー分野は不足している。

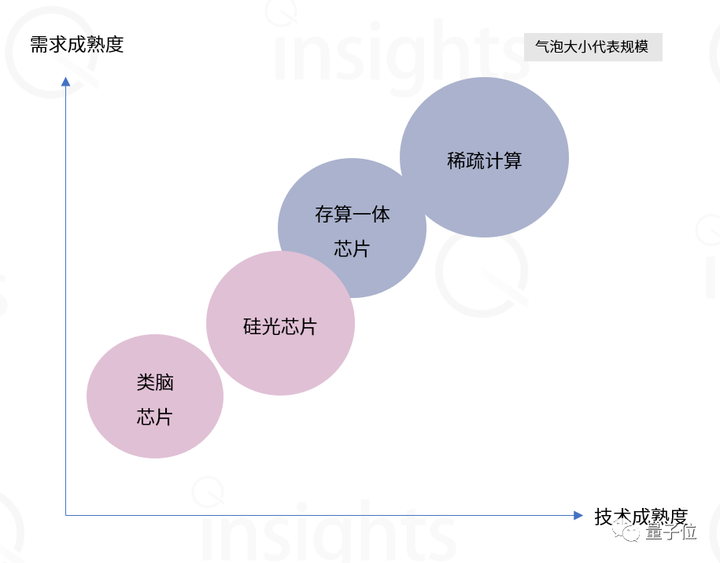

中期段階 (5 年以内) では、コンピューティング パワー層はトレーニングから推論への移行プロセスとなります。

この段階では、推論チップが主な需要側になります。 GPU の高い計算能力と高い消費電力、およびそれに伴う計算能力の浪費と比較して、推論チップはチップの計算効率比にさらに注意を払い、消費電力とコストをより適切に制御します。さらに、この段階は革新的なチップのチャンスでもあります。

アナリストは、メモリコンピューティング統合チップ、脳に着想を得たチップ、シリコン光チップなどの市場機会が増えると予想している。

推論段階では、トレーニング段階のクラウド コンピューティングよりもエッジ コンピューティングの方がチャンスが多くなります。

まず、推論段階に相当するアプリケーションは多様化する傾向にあり、要件の多様化によりクラウドコンピューティングでは計算能力の浪費が増大し、計算効率が低下します。

第 2 に、エッジ コンピューティングは、大規模なモデル推論に十分なコンピューティング能力を提供できます。

この段階では、AIサーバーメーカーの配当時期は徐々にピークに達し、需要は低コストの汎用サーバーにシフトし、チップもGPUからNPU/ASIC/FPGA/CPUなどへ移行し、他の形態が混在することになる。国内の革新的なチップのルートの中で、** は統合されたストレージとコンピューティング アーキテクチャの開発に楽観的です**。

チップの根底にあるイノベーションの利点が明らかになり始めており、ストレージとコンピューティングの統合、フォトニックチップ、頭脳型チップなどの真に革新的なテクノロジーを備えたチップメーカーが市場での役割を高めています。

AIGC のコンピューティング能力に必要なチップの種類はさらに多様です。

この段階の企業は、コンピューティング能力の規模を考慮するだけでなく、コンピューティング能力をより包括的に考慮する必要があり、消費電力とコストがコンピューティング能力の規模を超え、各モデル層の企業が気にする指標になる可能性があります。

レポートの取得

以下のリンクをクリックしてください。